Scienziati del Salk hanno sviluppato una nuova tecnica per misurare la forza e la plasticità delle sinapsi, supportando nuove ricerche su apprendimento e memoria e sul loro declino nell'invecchiamento e nelle malattie

A ogni giro che fai con un mazzo di carte mnemoniche (flashcard) con parole, le definizioni arrivano più rapidamente e più facilmente. Questo processo di apprendimento e memorizzazione di nuove informazioni rafforza connessioni importanti nel cervello. Il ricordo più facile di quelle nuove parole e definizioni che deriva dalla pratica è la prova che quelle connessioni neurali, chiamate sinapsi, possono diventare più forti o più deboli nel tempo, una caratteristica chiamata 'plasticità sinaptica'.

Quantificare la dinamica delle singole sinapsi può essere una sfida per i neuroscienziati, ma innovazioni computazionali recenti del Salk Institute, di La Jolla / California, potrebbero contribuire a cambiare la situazione e a rivelare nuove informazioni sul cervello.

Per capire come il cervello apprende e conserva le informazioni, gli scienziati cercano di quantificare quanto si è rafforzata una sinapsi dopo l'apprendimento e quanto può diventare più forte. La forza sinaptica può essere misurata osservando le caratteristiche fisiche delle sinapsi, ma è molto più difficile misurare la precisione della plasticità (se le sinapsi si indeboliscono o si rafforzano in modo consistente) e la quantità di informazioni che una sinapsi può immagazzinare.

Gli scienziati del Salk hanno creato un nuovo metodo per esplorare la forza sinaptica, la precisione della plasticità e la quantità di informazioni immagazzinate, pubblicando i dettagli su Neural Computation. Quantificare queste tre caratteristiche sinaptiche può aiutarci a capire meglio come gli esseri umani apprendono e ricordano, nonché come tali processi si evolvono nel tempo o si deteriorano con l’età o nelle malattie.

"Stiamo migliorando nell'identificare esattamente dove e come i singoli neuroni si collegano tra loro, ma abbiamo ancora molto da imparare sulle dinamiche di tali connessioni", afferma il professore Terrence Sejnowski del Salk, autore senior dello studio. “Abbiamo ora creato una tecnica per studiare la forza delle sinapsi, la precisione con cui i neuroni modulano quella forza e la quantità di informazioni che le sinapsi sono in grado di immagazzinare, arrivando a scoprire che il nostro cervello può immagazzinare 10 volte più informazioni di quanto si pensava finora".

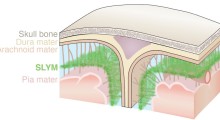

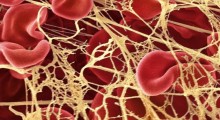

Quando un messaggio viaggia nel cervello, salta da un neurone all'altro, fluendo dall'estremità di un neurone a delle estensioni simili a viticci, chiamati dendriti, che sporgono da un altro. Ogni dendrite di un neurone è ricoperto da minuscole appendici bulbose (spine dendritiche), e all'estremità di ciascuna spina dendritica c'è la sinapsi, un minuscolo spazio dove le due cellule si incontrano e dove viene trasmesso un segnale elettrochimico. Sinapsi diverse vengono attivate per inviare messaggi diversi.

Alcuni messaggi attivano coppie di sinapsi, che sono una accanto all'altra sullo stesso dendrite. Queste coppie di sinapsi sono uno strumento di ricerca fantastico: se due sinapsi hanno storie di attivazione identiche, gli scienziati possono confrontare la forza di quelle sinapsi per trarre conclusioni sulla precisione della plasticità. Dato che attraverso queste due sinapsi è passato lo stesso tipo e la stessa quantità di informazioni, ciascuna di esse ha cambiato la forza allo stesso modo? Se è così, la loro precisione di plasticità è elevata.

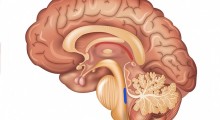

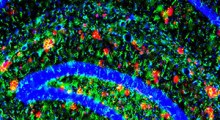

Il team del Salk ha applicato concetti della teoria dell’informazione per analizzare le coppie di sinapsi dell’ippocampo di ratto – una parte del cervello coinvolta nell’apprendimento e nella memoria – per verificarne forza, plasticità e precisione. La teoria dell'informazione è un modo matematico sofisticato di comprendere l'elaborazione dell'informazione come un segnale che viaggia in un canale rumoroso ed è ricostruito dall'altra parte.

Fondamentalmente, a differenza dei metodi usati in passato, la teoria dell'informazione tiene conto della rumorosità dei numerosi segnali e cellule del cervello, oltre a offrire un'unità discreta di informazione - un bit - per misurare la quantità di informazioni immagazzinate in una sinapsi.

"Abbiamo diviso le sinapsi in base alla forza, in 24 possibili categorie, quindi abbiamo confrontato coppie specifiche di sinapsi per determinare con quanta precisione viene modulata la forza di ciascuna sinapsi", afferma Mohammad Samavat, primo autore dello studio e ricercatore post-dottorato nel laboratorio di Sejnowski. “Siamo stati entusiasti di scoprire che le coppie avevano dimensioni delle spine dendritiche e forza sinaptica molto simili, il che significa che il cervello è altamente preciso quando rafforza o indebolisce le sinapsi nel tempo”.

Oltre a notare le somiglianze nella forza delle sinapsi all'interno di queste coppie, che si traduce in un alto livello di precisione della plasticità, il team ha anche misurato la quantità di informazioni contenute in ciascuna delle 24 categorie di forza. Nonostante le differenze nella dimensione di ogni spina dendritica, ciascuna delle 24 categorie di forza sinaptica conteneva una quantità simile di informazioni (tra 4,1 e 4,6 bit).

Rispetto alle tecniche precedenti, questo nuovo approccio che usa la teoria dell’informazione è più approfondito, poiché contabilizza il decuplo delle informazioni immagazzinate nel cervello rispetto a quanto ipotizzato finora, e scalabile, il che significa che può essere applicato a insiemi di dati di tipo e dimensione diversi per raccogliere informazioni su altre sinapsi.

"Questa tecnica sarà di enorme aiuto per i neuroscienziati", afferma Kristen Harris, prof.ssa dell'Università del Texas di Austin e coautrice dello studio. "Questa visione dettagliata sulla forza e sulla plasticità sinaptica potrebbe davvero dare impulso alla ricerca sull'apprendimento e sulla memoria, e possiamo usarla per esplorare questi processi in tutte le diverse parti del cervello umano, animale, giovane e vecchio".

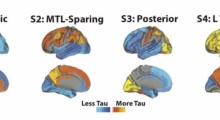

Sejnowski afferma che il lavoro futuro di progetti come la BRAIN Initiative dei National Institutes of Health, che ha creato un atlante delle cellule cerebrali umane nell’ottobre 2023, beneficerà di questo nuovo strumento. Oltre agli scienziati che catalogano tipi e comportamenti delle cellule cerebrali, la tecnica è interessante per coloro che studiano la mancata memorizzazione delle informazioni, come nell'Alzheimer.

Negli anni a venire, ricercatori di tutto il mondo potrebbero usare questa tecnica per fare scoperte entusiasmanti sulla capacità del cervello umano di apprendere nuove competenze, ricordare azioni quotidiane e archiviare informazioni a breve e lungo termine.

Fonte: Salk Institute for Biological Studies (> English)

Riferimenti: M Samavat, [+2], TJ Sejnowski. Synaptic Information Storage Capacity Measured With Information Theory. Neural Comput., 2024, DOI

Copyright: Tutti i diritti di testi o marchi inclusi nell'articolo sono riservati ai rispettivi proprietari.

Liberatoria: Questo articolo non propone terapie o diete; per qualsiasi modifica della propria cura o regime alimentare si consiglia di rivolgersi a un medico o dietologo. Il contenuto non rappresenta necessariamente l'opinione dell'Associazione Alzheimer OdV di Riese Pio X ma solo quella dell'autore citato come "Fonte". I siti terzi raggiungibili da eventuali collegamenti contenuti nell'articolo e/o dagli annunci pubblicitari sono completamente estranei all'Associazione, il loro accesso e uso è a discrezione dell'utente. Liberatoria completa qui.

Nota: L'articolo potrebbe riferire risultati di ricerche mediche, psicologiche, scientifiche o sportive che riflettono lo stato delle conoscenze raggiunte fino alla data della loro pubblicazione.

Associazione Alzheimer OdV

Associazione Alzheimer OdV