L'uso dell'intelligenza artificiale in medicina sta generando grande eccitazione e speranza per i progressi nei trattamenti.

Il termine Intelligenza Artificiale (IA) si riferisce generalmente alla capacità dei computer di imitare l'intelligenza umana e di apprendere. Ad esempio, con l'apprendimento automatico, gli scienziati stanno lavorando allo sviluppo di algoritmi che li aiuteranno a prendere decisioni in merito al trattamento del cancro. Sperano che i computer saranno in grado di analizzare immagini radiologiche e discernere quali tumori cancerosi risponderanno bene alla chemioterapia e quali no.

Ma l'IA in medicina solleva anche importanti sfide legali ed etiche. Molte di queste preoccupazioni riguardano la privacy, la discriminazione, i danni psicologici e la relazione medico-paziente. In un prossimo studio sostengo che i responsabili politici dovrebbero stabilire una serie di salvaguardie intorno all'intelligenza artificiale, proprio come quando sono diventati comuni i test genetici.

Potenziale di discriminazione

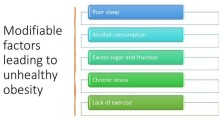

L'IA comporta l'analisi di grandi quantità di dati per discernere dei modelli, che vengono quindi usati per dare una probabilità agli eventi futuri. In medicina, i set di dati possono provenire da cartelle cliniche elettroniche e dichiarazioni di assicurazione sanitaria, ma anche da diverse fonti sorprendenti. L'IA può attingere a dati di acquisto, dati sul reddito, precedenti penali e persino informazioni dai social media sulla salute di un individuo.

I ricercatori stanno già usando l'IA per prevedere molte condizioni mediche. Queste includono malattie cardiache, ictus, diabete, declino cognitivo, futuro abuso di oppioidi e persino suicidio. Ad esempio, Facebook utilizza un algoritmo che effettua previsioni di suicidio basate su post con frasi come "Stai bene?" abbinate a "Addio" e "Per favore, non farlo".

Questa capacità predittiva dell'IA solleva importanti preoccupazioni etiche nella sanità. Se l'IA genera previsioni sulla tua salute, credo che un giorno le informazioni potrebbero essere incluse nelle tue cartelle cliniche elettroniche.

Chiunque abbia accesso ai tuoi dati sanitari potrebbe quindi vedere le previsioni sul declino cognitivo o sull'abuso di oppiacei. Dozzine o addirittura centinaia di medici e amministratori consultano le cartelle cliniche dei pazienti nel corso di un trattamento medico. Inoltre, i pazienti stessi spesso autorizzano gli altri ad accedere ai loro registri: ad esempio, quando fanno domanda di assunzione o per un'assicurazione sulla vita.

Anche i giganti del settore dei broker di dati come LexisNexis e Acxiom stanno estraendo dati personali e stanno svolgendo attività di IA. Potrebbero quindi vendere previsioni mediche a terze parti interessate, come operatori di marketing, datori di lavoro, istituti di credito, assicuratori sulla vita e altri. Poiché queste aziende non sono fornitori di servizi sanitari o assicuratori, le regole HIPAA sulla privacy non si applicano a loro. Pertanto, non devono chiedere ai pazienti l'autorizzazione per ottenere le loro informazioni e possono divulgarle liberamente.

Tali divulgazioni possono portare a discriminazioni. I datori di lavoro, ad esempio, sono interessati ai lavoratori che sono sani e produttivi, con poche assenze e bassi costi medici. Se ritengono che alcuni richiedenti svilupperanno malattie in futuro, probabilmente li scarteranno. Anche finanziatori, proprietari terrieri, assicuratori sulla vita e altri potrebbero prendere decisioni avverse sugli individui in base alle previsioni dell'IA.

Mancanza di protezioni

L'Americans with Disabilities Act non proibisce la discriminazione basata su futuri problemi di salute. Si applica solo ai disturbi attuali e passati. In risposta ai test genetici, il Congresso ha emanato la legge sulla non discriminazione per informazioni genetiche. Questa legge vieta ai datori di lavoro e agli assicuratori sanitari di prendere in considerazione le informazioni genetiche e di prendere decisioni basate su ipotesi correlate sulle future condizioni di salute delle persone. Nessuna legge impone un divieto simile per quanto riguarda i dati predittivi non genetici.

Le previsioni sulla salute dell'IA possono anche portare a danni psicologici. Ad esempio, molte persone potrebbero essere traumatizzate apprendendo che probabilmente subiranno un declino cognitivo più avanti nella vita. È anche possibile che le persone ottengano previsioni sulla salute direttamente dalle entità commerciali che hanno acquistato i loro dati. Immagina di ottenere la notizia che sei a rischio di demenza attraverso una pubblicità elettronica che ti spinge ad acquistare prodotti che migliorano la memoria.

Quando si tratta di test genetici, si consiglia ai pazienti di cercare una consulenza genetica in modo da poter decidere attentamente se sottoporsi al test e comprendere meglio i risultati del test. Però non abbiamo consulenti di IA che forniscono servizi simili ai pazienti.

Ancora un'altra preoccupazione riguarda la relazione medico-paziente. L'intelligenza artificiale diminuirà il ruolo dei medici? Saranno i computer a fare previsioni, diagnosi e suggerimenti di trattamento, così che i medici implementeranno semplicemente le istruzioni dei computer? Come si sentiranno i pazienti nei confronti dei loro medici se i computer avranno più voce in capitolo nel prendere decisioni mediche?

Queste preoccupazioni sono esacerbate dal fatto che le previsioni dell'IA sono tutt'altro che infallibili. Molti fattori possono contribuire agli errori. Se i dati utilizzati per sviluppare un algoritmo sono difettosi, ad esempio se utilizzano cartelle cliniche che contengono errori, la soluzione dell'algoritmo sarà errata. Pertanto, i pazienti possono subire discriminazioni o danni psicologici quando in realtà non sono a rischio dei disturbi previsti.

E' richiesta cautela

Cosa si può fare per proteggere il pubblico americano? In un lavoro precedente ho discusso dell'ampliamento della norma HIPAA sulla privacy in modo che copra chiunque gestisca le informazioni sanitarie a fini commerciali. Le protezioni della privacy dovrebbero applicarsi non solo agli operatori sanitari e agli assicuratori, ma anche alle imprese commerciali. Ho anche sostenuto che il Congresso dovrebbe modificare l'American with Disabilities Act per vietare la discriminazione basata sulle previsioni di malattie future.

I medici che forniscono ai pazienti previsioni basate sull'IA dovrebbero assicurarsi di essere completamente istruiti sui pro e contro di tali previsioni. Esperti dovrebbero consigliare i pazienti in base all'IA proprio come fanno i professionisti qualificati per i test genetici.

La prospettiva dell'IA può sovra-intimorire le persone. Tuttavia, per garantire che l'IA promuova veramente il benessere dei pazienti, medici, ricercatori e responsabili politici devono riconoscere i suoi rischi e procedere con cautela.

Fonte: Sharona Hoffman, professoressa di diritto sanitario e di bioetica alla Case Western Reserve University

Pubblicato su The Conversation (> English text) - Traduzione di Franco Pellizzari.

Copyright: Tutti i diritti di eventuali testi o marchi citati nell'articolo sono riservati ai rispettivi proprietari.

Liberatoria: Questo articolo non propone terapie o diete; per qualsiasi modifica della propria cura o regime alimentare si consiglia di rivolgersi a un medico o dietologo. Il contenuto non rappresenta necessariamente l'opinione dell'Associazione Alzheimer onlus di Riese Pio X ma solo quella dell'autore citato come "Fonte". I siti terzi raggiungibili da eventuali collegamenti contenuti nell'articolo e/o dagli annunci pubblicitari sono completamente estranei all'Associazione, il loro accesso e uso è a discrezione dell'utente. Liberatoria completa qui.

Nota: L'articolo potrebbe riferire risultati di ricerche mediche, psicologiche, scientifiche o sportive che riflettono lo stato delle conoscenze raggiunte fino alla data della loro pubblicazione.

Associazione Alzheimer OdV

Associazione Alzheimer OdV