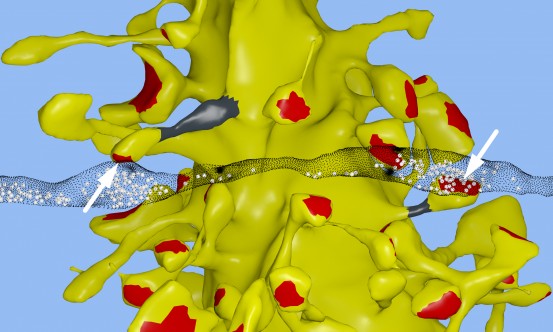

In una ricostruzione grafica del tessuto cerebrale dell'ippocampo, si nota l'insolita presenza di due sinapsi dell'assone di un neurone (striscia traslucida nera) che formano due spine sullo stesso dendrite di un secondo neurone (giallo). Si vedono i terminali separati da un assone del neurone in contatto sinaptico con due spine (frecce) sullo stesso dendrite di un secondo neurone dell'ippocampo. I volumi della testa della spina, le aree di contatto sinaptiche (rosso), i diametri del collo (grigio) e il numero di vescicole presinaptiche (sfere bianche) di queste due sinapsi sono quasi identici. (Fonte: Salk Institute)Ricercatori e collaboratori del Salk Institute hanno acquisito una visione cruciale della dimensione delle connessioni neurali, fissando la capacità del cervello di memorizzare di gran lunga oltre le stime comuni.

In una ricostruzione grafica del tessuto cerebrale dell'ippocampo, si nota l'insolita presenza di due sinapsi dell'assone di un neurone (striscia traslucida nera) che formano due spine sullo stesso dendrite di un secondo neurone (giallo). Si vedono i terminali separati da un assone del neurone in contatto sinaptico con due spine (frecce) sullo stesso dendrite di un secondo neurone dell'ippocampo. I volumi della testa della spina, le aree di contatto sinaptiche (rosso), i diametri del collo (grigio) e il numero di vescicole presinaptiche (sfere bianche) di queste due sinapsi sono quasi identici. (Fonte: Salk Institute)Ricercatori e collaboratori del Salk Institute hanno acquisito una visione cruciale della dimensione delle connessioni neurali, fissando la capacità del cervello di memorizzare di gran lunga oltre le stime comuni.

Il nuovo lavoro risponde anche alla vecchia questione del motivo per cui il cervello ha una efficienza energetica così alta e potrebbe aiutare gli ingegneri a costruire computer che sono incredibilmente potenti, ma che al contempo conservano l'energia.

"Si tratta di una vera e propria bomba nel campo delle neuroscienze", dice Terry Sejnowski, professore del Salk e co-autore senior della ricerca, pubblicata in eLife. "Abbiamo trovato la chiave per svelare il principio di progettazione per cui i neuroni dell'ippocampo funzionano a bassa energia, ma ad alta potenza di calcolo. Le nostre nuove misurazioni della capacità di memoria del cervello aumentano le stime conservative di un fattore 10, fino ad almeno un petabyte, nello stesso campo del World Wide Web".

I nostri ricordi e pensieri sono il risultato di modelli di attività elettrica e chimica nel cervello. Una parte fondamentale delle attività avviene quando le ramificazioni dei neuroni, proprio come fili elettrici, interagiscono in determinati incroci, chiamati sinapsi. Un 'filo' in uscita (un assone) da un neurone si collega al 'filo' in ingresso (un dendrite) di un secondo neurone. I segnali viaggiano attraverso la sinapsi in forma di sostanze chimiche chiamate neurotrasmettitori, per dire al neurone ricevente se trasmettere un segnale elettrico ad altri neuroni. Ogni neurone può avere migliaia di queste sinapsi con migliaia di altri neuroni.

"Quando abbiamo inizialmente ricostruito ogni dendrite, assone, processo gliale e sinapsi da un volume dell'ippocampo delle dimensioni di un singolo globulo rosso, siamo rimasti un po' sconcertati dalla complessità e dalla diversità tra le sinapsi", dice Kristen Harris, co-autrice senior del lavoro e professoressa di neuroscienze all'Università del Texas di Austin. "Mentre avevo sperato di capire da queste ricostruzioni dettagliate i principi fondamentali sul modo in cui è organizzato il cervello, sono stata veramente sorpresa dalla precisione ottenuta nelle analisi di questo rapporto".

Le sinapsi sono ancora un mistero, anche se la loro disfunzione può causare una serie di malattie neurologiche. Le sinapsi più grandi (con più superficie e vescicole di neurotrasmettitori) sono quelle più forti, rendendole più propense a attivare i neuroni circostanti, rispetto alle sinapsi medie o piccole.

Il team del Salk, mentre formava la ricostruzione in 3D del tessuto dell'ippocampo (centro della memoria del cervello) di ratto, ha notato qualcosa di insolito. In alcuni casi, un singolo assone di un neurone formava due sinapsi che raggiungevano un singolo dendrite di un secondo neurone, indicando che il primo neurone sembrava inviare un messaggio duplice al neurone ricevente.

In un primo momento, i ricercatori non hanno fatto molto caso a questo duplicità, che avviene per circa il 10 per cento del tempo nell'ippocampo. Ma Tom Bartol, uno scienziato interno del Salk, ha avuto un'idea: se si potesse misurare la differenza tra due sinapsi molto simili come queste, si potrebbero ottenere informazioni sulle dimensioni sinaptiche, che finora erano state classificate nel settore solo come piccole, medie e grandi. Per fare questo, i ricercatori hanno usato la microscopia avanzata e algoritmi di calcolo che avevano sviluppato per visualizzare il cervello dei ratti e ricostruire la connettività, le forme, i volumi e la superficie del tessuto cerebrale a un livello nanomolecolare.

Gli scienziati si aspettavano che le sinapsi fossero più o meno simili in termini di dimensioni, ma sono stati sorpresi di scoprire che le sinapsi erano quasi identiche. "Siamo stati sorpresi di scoprire che la differenza nelle dimensioni delle coppie di sinapsi erano molto piccole, erano diverse in media solo di circa l'8 per cento per dimensione. Nessuno pensava che ci sarebbe stata una tale piccola differenza. Questo è un tiro mancino della natura", spiega Bartol.

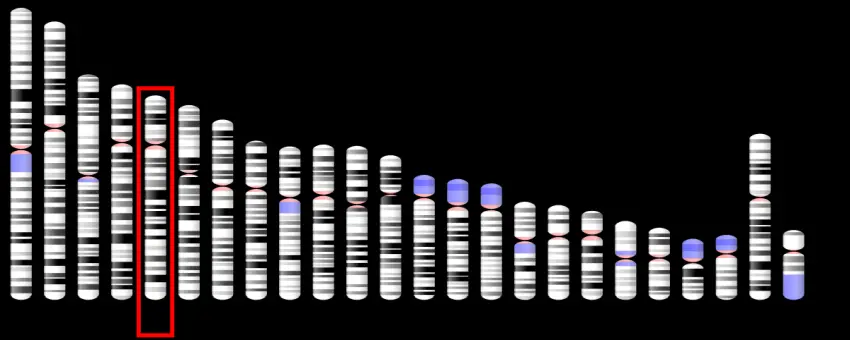

Poiché la capacità di memoria dei neuroni dipende dalle dimensioni delle sinapsi, questa differenza dell'otto per cento si è rivelata un numero chiave che il team ha inserito nei modelli algoritmici del cervello per misurare la quantità di informazioni che potrebbero essere immagazzinate nelle connessioni sinaptiche. Prima si pensava che la gamma di dimensioni tra le sinapsi minime e massime fosse un fattore di 60, e che la maggior parte erano piccole.

Ma, armati della consapevolezza che le sinapsi di qualsiasi dimensione possono variare con incrementi del +/-8 per cento tra le dimensioni in un fattore di 60, il team ha determinato che ci potrebbero essere circa 26 categorie di dimensioni delle sinapsi, e non solo alcune. "I nostri dati suggeriscono che ci sono dimensioni discrete di sinapsi 10 volte di più di quanto si pensasse", spiega Bartol. In termini informatici, 26 formati di sinapsi corrispondono a circa 4,7 'bit' di informazioni. In precedenza, si pensava che il cervello era capace di immagazzinare solo 1 o 2 bit di memoria a breve e lungo termine nell'ippocampo.

"E' un ordine in più di magnitudine di precisione di quello che chiunque abbia mai immaginato", dice Sejnowski. Ciò che rende questa precisione sconcertante è che le sinapsi dell'ippocampo sono notoriamente inaffidabili. Quando un segnale viaggia da un neurone all'altro, attiva in genere quel secondo neurone solo dal 10 al 20 per cento del tempo. "Ci eravamo spesso chiesti come la notevole precisione del cervello possa determinare una tale inaffidabilità nelle sinapsi", spiega Bartol.

Una risposta, a quanto pare, è il costante adeguamento delle sinapsi, che fa la media dei tassi di successo e fallimento nel tempo. Il team ha usato i nuovi dati e un modello statistico per scoprire quanti segnali ci vogliono perchè una coppia di sinapsi arrivi a quella differenza dell'8 per cento. I ricercatori hanno calcolato che per le sinapsi più piccole servono circa 1.500 eventi per indurre un cambiamento nella dimensione / capacità (20 minuti) e per quelle più grandi, solo 200 eventi di segnalazione (da 1 a 2 minuti) causano un cambiamento.

"Questo significa che ogni 2 o 20 minuti, le nostre sinapsi vanno su o giù alla dimensione successiva. Le sinapsi si auto-adeguano in base ai segnali che ricevono", spiega Bartol.

"Il nostro lavoro precedente aveva accennato alla possibilità che spine e assoni della stessa sinapsi potessero essere simili in termini di dimensioni, ma la realtà della precisione è davvero notevole e pone le basi per modi completamente nuovi di pensare al cervello e ai computer", dice Harris. "Il lavoro derivante da questa collaborazione ha aperto un nuovo capitolo nella ricerca dei meccanismi di apprendimento e memoria". Harris aggiunge che i risultati suggeriscono altre domande da chiarire; per esempio, se regole analoghe valgono per le sinapsi di altre aree del cervello e come tali regole differiscono durante lo sviluppo e come le sinapsi cambiano durante le fasi iniziali dell'apprendimento.

"Le implicazioni di quello che abbiamo trovato sono di vasta portata", aggiunge Sejnowski. "Nascosta sotto l'apparente caos e disordine del cervello ci era nascosta una precisione sottostante alle dimensioni e le forme delle sinapsi".

***

I risultati offrono anche una spiegazione valida dell'efficienza sorprendente del cervello. Il cervello adulto sveglio genera solo circa 20 watt di potenza continua, tanto quanto una lampadina molto fioca. La scoperta potrebbe aiutare gli scienziati informatici del Salk a generare computer ultraprecisi, ma ad alta efficienza energetica, in particolare quelli che utilizzano "l'apprendimento profondo" e le reti artificiali neurali, tecniche capaci di apprendimento e analisi sofisticati, come il riconoscimento della parola e degli oggetti e la traduzione.

"Questo trucco del cervello indica assolutamente un modo di progettare computer migliori", dice Sejnowski. "Usare la trasmissione probabilistica risulta essere altrettanto accurato e richiede molta meno energia sia per i computer che per il cervello".

Altri autori della ricerca erano Cailey Bromer del Salk Institute; Justin Kinney del McGovern Institute for Brain Research; e Michael A. Chirillo e Jennifer N. Bourne della University of Texas di Austin. Il lavoro è stato supportato dal NIH e dall'Howard Hughes Medical Institute.

Fonte: Salk Institute (> English text) - Traduzione di Franco Pellizzari.

Riferimenti: Terrence J Sejnowski et al. Nanoconnectomic upper bound on the variability of synaptic plasticity. eLife, January 2016 DOI: 10.7554/eLife.10778.001

Copyright: Tutti i diritti di eventuali testi o marchi citati nell'articolo sono riservati ai rispettivi proprietari.

Liberatoria: Questo articolo non propone terapie o diete; per qualsiasi modifica della propria cura o regime alimentare si consiglia di rivolgersi a un medico o dietologo. Il contenuto non dipende da, nè impegna l'Associazione Alzheimer onlus di Riese Pio X. I siti terzi raggiungibili da eventuali links contenuti nell'articolo e/o dagli annunci pubblicitari sono completamente estranei all'Associazione, il loro accesso e uso è a discrezione dell'utente. Liberatoria completa qui.

Nota: L'articolo potrebbe riferire risultati di ricerche mediche, psicologiche, scientifiche o sportive che riflettono lo stato delle conoscenze raggiunte fino alla data della loro pubblicazione.

Associazione Alzheimer OdV

Associazione Alzheimer OdV